全民「大擦边、大压抑」时代,AI 是什么角色?

全民「大擦边、大压抑」时代,AI 是什么角色?这两周,字节新发布的 AI 视频模型 Seedance2.0 特别火,真正的全民热议。 我给我爹看了几个模型生成的视频,他的反应特别有代表性。看完以后他跟我说了一句话:「你别胡说八道,这就是真人啊。」

这两周,字节新发布的 AI 视频模型 Seedance2.0 特别火,真正的全民热议。 我给我爹看了几个模型生成的视频,他的反应特别有代表性。看完以后他跟我说了一句话:「你别胡说八道,这就是真人啊。」

「来自中国的 Seedance 2.0 将成为最先进的技术。」

这两天,AI 视频圈被偷摸摸上线的 Seedance 2.0 刷屏了。在 AI 视频领域颇有影响力的博主海辛,在即刻分享了自己对它的观点:「Seedance 2.0 是我 26 年来最大的震撼」、「我觉得它碾压 Sora2」。

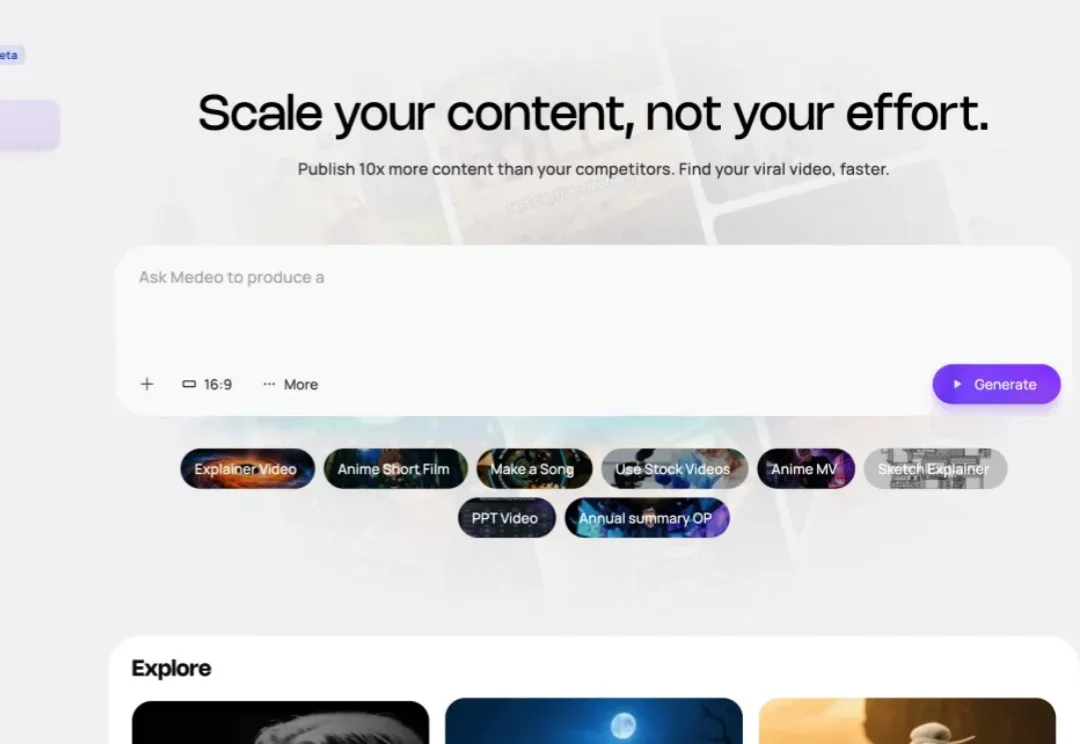

大家好,我是刀哥。做过大厂研发、做过出海硬件,现在深耕 AI 视频、AI 漫剧。 深耕了几个月,一分钱没赚到,因为时间有限,上架困难,也没有聚焦。。。

Claude Skills 最近在社交媒体上刷屏。它让 AI 从会聊天变成会干活。把专业能力打包成模块,用户只用斜杠 / 一下就能选择对应的 Skills。

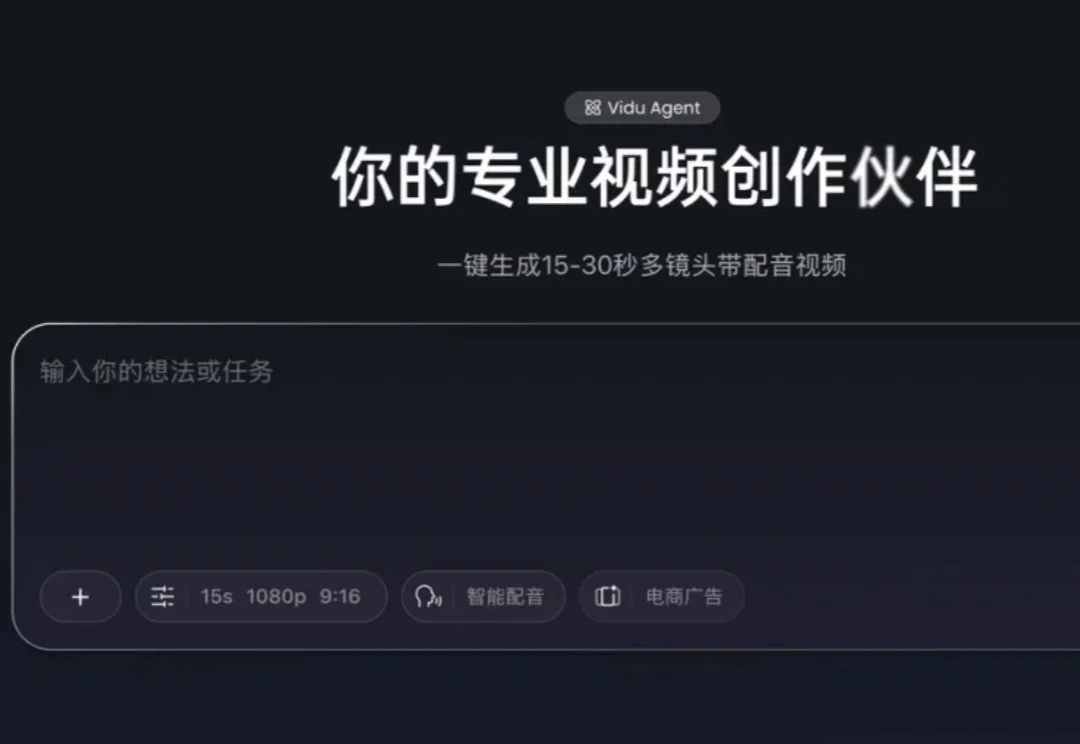

将视频制作门槛降至新低。

短视频平台把创作门槛压进手机屏幕,完成了一次“即创即消”的效率革命。

2025 年还有一周结束,年底,AI 视频圈又卷起来了。

过去这几个月,大家的朋友圈大概都被极其逼真的 AI 视频刷过屏,比如刀切一切、片场穿梭合影等等。它们的光影和细节如此逼真,近乎达到了「以假乱真」的地步。

AI 让每个人都能制作视频,但许多 AI 视频创作工具缺乏音频支持。Mirelo 正在开发能根据视频内容匹配音效的 AI 技术。